|

|

Хотите расти в поисковиках на 20% быстрее?

Тогда эта статья для вас. Мы в Wizard.Sape давно проводим технические и поисковые аудиты и можем констатировать, что сайты, для которых был проведен подобный аудит и внесены правки, растут в среднем на 20% динамичнее, чем остальные ресурсы, продвигаемые в нашей системе. Это – средняя величина, а бывает и так, что сайт вовсе не может вырасти из-за технических проблем. А между тем, получить такой бонус довольно просто – нужно лишь правильно подготовиться к встрече с поисковой системой.

|

|

|

|

Готовимся к «свиданию» с поисковой системой |

|

|

|

|

|

Первое свидание… Что может быть важнее и волнительнее? Чтобы произвести на своего визави отличное впечатление, мы выбираем самый красивый наряд и дорогой парфюм, приводим в порядок прическу и лицо, заранее продумываем темы для разговора и комплименты… А вот когда на «первое свидание» с поисковой системой нужно отправить наш сайт, мы почему-то подходим к его подготовке совсем не так тщательно. Давайте не будем эгоистами, и поможем нашим веб-ресурсам предстать в глазах Яндекса и Google в лучшем виде.

Что же нужно знать, чтобы собрать сайт на «первое свидание»? Поисковые системы, в отличие от людей, встречают веб-ресурсы не столько по «одежке», то есть по дизайну, сколько по их техническому состоянию. Именно об этом аспекте подготовки к продвижению мы и поговорим в сегодняшнем выпуске нашей рассылки.

|

|

|

|

|

|

|

|

Заявляем о серьезных намерениях: стабильность сайта |

|

|

|

|

|

Когда вы хотите серьезных и длительных отношений, вы стремитесь уже на первом свидании показать, что вы – не ветреный донжуан, а надежное «плечо», на которое всегда можно положиться. Вашему сайту для завоевания «любви» поисковых систем необходимо доказать то же самое. Что для этого нужно? Конечно же, хороший хостинг.

Когда вы арендуете хостинг, то вместе с вашим сайтом на сервере может располагаться еще несколько ресурсов. С ростом числа сайтов и количества обращений к ним (то есть их посещаемости) мощности сервера может не хватить. Из-за этого он начнет «тормозить», сайты будут медленно загружаться, а то и вовсе станут недоступны. Далеко не каждый человек готов ждать несколько минут или бессчетное число раз нажимать F5, чтобы увидеть нужную страницу, поэтому посетители будут просто уходить с сайта. А поисковые «пауки» решат, что раз URL не грузится, значит, его уже не существует. В итоге страницы выпадут из индекса, а позиции в поисковиках снизятся из-за возросшего числа отказов. Вот пример такого случая (сайт был недоступен несколько часов):

Поисковик не смог загрузить часть страниц сайта и просто исключил их из индекса. В результате ресурс на полмесяца лишился достигнутых позиций в ТОПе.Чтобы не допустить нестабильной работы сайта, воспользуйтесь простыми советами. Для начала начните контролировать работу хостинга, тем более это можно делать совершенно бесплатно. Установите Яндекс.Метрику на ваш сайт, и система будет автоматически уведомлять вас о недоступности ресурса. Для более детального анализа используйте сайт host-tracker.com – после регистрации на нем вы не только будете получать сообщения о недоступности сайта, но и сможете просматривать развернутые отчеты за день, неделю, месяц и любой другой период времени. Поисковик не смог загрузить часть страниц сайта и просто исключил их из индекса. В результате ресурс на полмесяца лишился достигнутых позиций в ТОПе.Чтобы не допустить нестабильной работы сайта, воспользуйтесь простыми советами. Для начала начните контролировать работу хостинга, тем более это можно делать совершенно бесплатно. Установите Яндекс.Метрику на ваш сайт, и система будет автоматически уведомлять вас о недоступности ресурса. Для более детального анализа используйте сайт host-tracker.com – после регистрации на нем вы не только будете получать сообщения о недоступности сайта, но и сможете просматривать развернутые отчеты за день, неделю, месяц и любой другой период времени.

Озаботиться стабильностью работы сайта нужно еще до начала SEO-мероприятий. Если хостинг кажется вам ненадежным или мощности обычного сервера недостаточно для Вашего ресурса, переходите на выделенный сервер. И не старайтесь сэкономить – выбирайте только по-настоящему известных и авторитетных хостинг-провайдеров с хорошими отзывами и гарантиями.

|

|

|

|

|

|

|

|

Уделяем внимание мелочам: .htaccess, robots.txt, sitemap.xml |

|

|

|

|

|

Любой, кто хоть раз был на свидании, знает, насколько важны для первого впечатления бывают незначительные на первый взгляд вещи. Одно неосторожное слово или единственная неуместная улыбка могут свести на «нет» все усилия понравиться предмету своих воздыханий. В отношениях сайта и поисковых систем все происходит точно также. Поэтому давайте обратимся к техническим «мелочам».

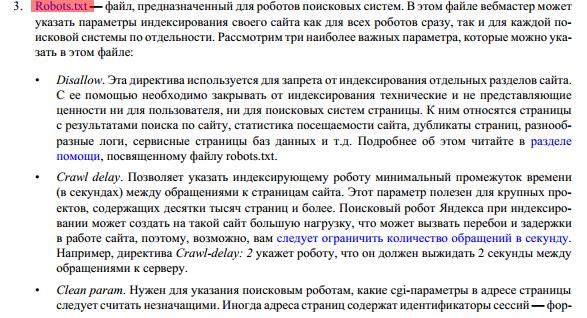

Перед началом продвижения обязательно обратите внимание на файлы .htaccess, robots.txt и sitemap.xml. .htaccess содержит настройки веб-сервера Apache. Файл robots.txt — своеобразный «сценарий общения» сайта и роботов поисковых систем. В нем вебмастер может указать параметры индексирования своего ресурса как для всех роботов сразу, так и для «пауков» каждой поисковой системы по отдельности. Файл Sitemap — это файл с информацией о подлежащих индексированию страницах сайта.

О том, насколько важны вышеуказанные файлы, пишет и сам поисковик:

Подробнее на http://help.yandex.ru/help.yandex.ru/webmaster/files/recommendations.pdf иhttp://help.yandex.ru/webmaster/indexing-options/sitemap.xmlФайл .htaccess нужно настроить так, чтобы ваш сайт открывался и с префиксом www, и без него, но при этом был установлен 301 редирект на главное зеркало ресурса (либо все с www, либо все без www). Правильно определите индексную страницу, учитывая, что она не должна быть доступна по нескольким адресам. Проверить это просто: откройте Ваш сайт и укажите в конце index.html или index.php. Как и с тем, что главное зеркало сайта должно быть единственным, должна быть единственной и главная страница. Фактически это расценивается как дублирование страниц, о чем в рекомендациях для вебмастеров у Яндекса есть целая глава. Подробнее на http://help.yandex.ru/help.yandex.ru/webmaster/files/recommendations.pdf иhttp://help.yandex.ru/webmaster/indexing-options/sitemap.xmlФайл .htaccess нужно настроить так, чтобы ваш сайт открывался и с префиксом www, и без него, но при этом был установлен 301 редирект на главное зеркало ресурса (либо все с www, либо все без www). Правильно определите индексную страницу, учитывая, что она не должна быть доступна по нескольким адресам. Проверить это просто: откройте Ваш сайт и укажите в конце index.html или index.php. Как и с тем, что главное зеркало сайта должно быть единственным, должна быть единственной и главная страница. Фактически это расценивается как дублирование страниц, о чем в рекомендациях для вебмастеров у Яндекса есть целая глава.

Подробнее на http://help.yandex.ru/help.yandex.ru/webmaster/files/recommendations.pdfПри составлении файла robots.txt обязательно сделайте следующее: Подробнее на http://help.yandex.ru/help.yandex.ru/webmaster/files/recommendations.pdfПри составлении файла robots.txt обязательно сделайте следующее:

- пропишите главное зеркало сайта с помощью директивы Host;

- закройте от индексации страницы поиска по сайту, мусорные и малоинформативные страницы, дубли страниц, служебные разделы и т. п.;

- укажите адрес карты сайта в формате XML.

Большинство современных систем управления контентом сайта (CMS) автоматически составляют XML-карту ресурса. Настройте генерацию этого файла, указав какие страницы и разделы будут выгружаться, установите приоритет файлов. Такая карта ускорит индексацию сайта. Более подробно о карте сайта см. на страницеhttp://help.yandex.ru/webmaster/indexing-options/sitemap.xml.

|

|

|

|

|

|

|

|

Приводим в порядок «здоровье» сайта: избавление и защита от вирусов |

|

|

|

|

|

Пойдете ли вы на первое свидание с высокой температурой, кашлем и насморком? Конечно же, нет, ведь в таком состоянии нормального общения не получится, да и мало кто захочет проводить время с человеком, от которого можно заразиться неприятной болезнью.

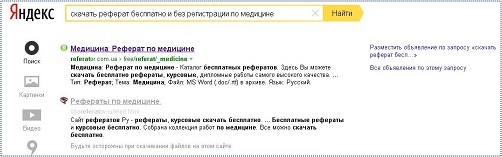

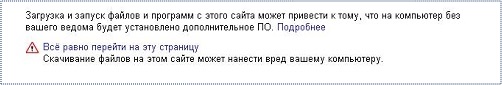

Сайты, как известно, тоже могут «болеть». Поисковые системы сразу же вычисляют ресурсы с вирусами и «награждают» их непривлекательными надписями об опасности для пользователей:

При попытке перейти на такой сайт вы увидите страницу с дополнительным предупреждением: При попытке перейти на такой сайт вы увидите страницу с дополнительным предупреждением:

Если не удалить вредоносное ПО, то в скором времени ресурс окажется на нижних строчках рейтинга. Поэтому оберегайте Ваш сайт от вирусов: вовремя меняйте пароли доступа к FTP, панели управления и т. п., составляйте сложные пароли и не передавайте их средствами электронных систем, регулярно проверяйте компьютер на наличие вредоносного кода и вовремя обновляйте антивирусное ПО. Ваша безопасность в ваших руках. Если не удалить вредоносное ПО, то в скором времени ресурс окажется на нижних строчках рейтинга. Поэтому оберегайте Ваш сайт от вирусов: вовремя меняйте пароли доступа к FTP, панели управления и т. п., составляйте сложные пароли и не передавайте их средствами электронных систем, регулярно проверяйте компьютер на наличие вредоносного кода и вовремя обновляйте антивирусное ПО. Ваша безопасность в ваших руках.

|

|

|

|

|

|

|

|

Устраняем «злобного близнеца»: борьба с дублями страниц |

|

|

|

|

|

Представьте, что у вас есть злобный брат близнец. Он тайно пробирается на каждое ваше свидание, и как только вы на секунду отлучитесь от своего собеседника, представляется Вами и портит все произведенное за вечер впечатление. Неприятная ситуация, не правда ли? А ведь именно так происходит с сайтами, страницы которых имеют дубли.

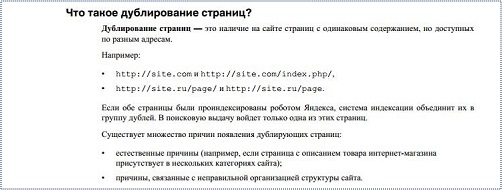

Дубли — это страницы одного сайта, которые содержат полностью идентичный контент, но имеют различные URL-адреса. Наличие таких страниц чревато ошибками индексации: поисковая система пытается исключать дубли из индекса и индексирует только одну копию, которую определяет как оригинал. Часто при этом поисковик выбирает в качестве оригинала вовсе не ту страницу, которую вы продвигаете, а один из ее дублей. Все ссылки, проставленные на продвигаемую страницу, в этом случае фактически работают вхолостую.

Чтобы избавиться от «злобного близнеца» вашего сайта, вам нужно устранить причину появления дублей или закрыть их от индексации. Также можно использовать тег <link rel=»canonical» …> или директиву Clean-Param (для Яндекса), для указания страницы-оригинала в каждой группе дублей.

|

|

|

|

|

|

|

|

И еще несколько полезных советов |

|

|

|

|

|

Я рассказал вам только о самых главных этапах подготовки сайта к «свиданию» с поисковой системой. Но это далеко не все, о чем вам нужно подумать до начала продвижения. Коротко перечислю распространенные технические ошибки, которых ни в коем случае не должно быть у вашего ресурса:

- некорректные ответы сервера, в том числе на запросы к несуществующим страницам;

- временные и циклические редиректы;

- страницы с долгим откликом сервера;

- некорректные мета-теги и заголовки страниц;

- «битые» ссылки и изображения.

|

|

|

|

|

|

|

|

Комплексная проверка в Wizard.Sape |

|

|

|

|

|

Как уже говорилось в начале, мы давно проводим технические и поисковые аудиты, и согласно нашей статистике, сайты, для которых был проведен подобный аудит, растут на 20% быстрее, чем те, которые пренебрегают своей «технической гигиеной».

Наш стандартный поисковый аудит стоит 8 000 рублей. Конечно, далеко не каждый владелец сайта или оптимизатор готов отдать 8 000 рублей за аудит, но он нужен каждому ресурсу. Поэтому для тех проектов, которые продвигаются в системе Wizard.Sape есть возможность провести автоматизированный технический аудит всего за 490 рублей. Просто перейдите в раздел http://www.seowizard.ru/siteaudit/ или кликните на ссылку«Тех. анализ» напротив вашего проекта:

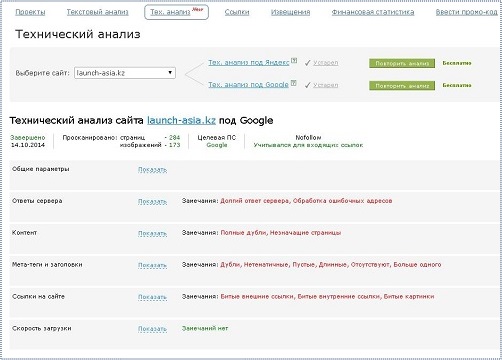

Проверка длится всего несколько часов. По результатам проверки Вы получите отчет следующего вида: Проверка длится всего несколько часов. По результатам проверки Вы получите отчет следующего вида:

Даже беглый взгляд на отчет для этого сайта позволяет оценить «уровень бедствия» и представить, как трудно будет продвинуть такой ресурс без исправления технических ошибок. Даже беглый взгляд на отчет для этого сайта позволяет оценить «уровень бедствия» и представить, как трудно будет продвинуть такой ресурс без исправления технических ошибок.

|

|

|

|

|

|

|

|

А что думают заказчики технического аудита? |

|

|

|

|

|